L’ultimo mese è stato particolarmente impegnativo e non mi ha lasciato il tempo di leggere e scrivere come avrei desiderato: la serie iniziata nel primo numero su tecnologie e paradigmi è destinata quindi a proseguire in modo intermittente; non è necessariamente un male visto che ciò mi consente di alternare gli argomenti e di spezzare un po’ il ritmo.

Avendo a disposizione solo i ritagli di tempo, mi sono rilassato come al posto mio avrebbe fatto qualunque buon geek (che è il modo in cui i vecchi nerd chiamano se stessi) ovvero piazzandomi davanti a un computer. Ho installato Stable Diffusion sul mio Mac mini, ho provato modelli, estensioni, plug-in, applicazioni, ho fatto un giro con Midjourney, mi sono letto forum, ho seguito tutorial, ho ascoltato interviste, ho generato immagini. Lo so: uno strano concetto di relax.

It's always insane to me that pics like these look more realistic than most photos posted on Instagram due to photo editing today.

—Broccolibox on Reddit

Questo commento sui recenti prodotti dell’intelligenza artificiale del redditor Broccolibox condensa benissimo lo stato dell’arte nel nostro attuale “mondo delle immagini” e anticipa una delle grandi trasformazioni cui stiamo per assistere.

Stable Diffusion, cui il nostro Broccolibox si riferisce (e, sì, ho scelto la citazione per lo username non meno che per il contenuto), è un modello di Generative AI del tipo “text-to-image”: si fornisce un input testuale e se ne ottiene una rappresentazione visuale (può fare più di così, ma per ora ci accontentiamo).

Applicazioni di questo tipo sono recenti ma non recentissime: da mesi gli utenti di Discord si divertono a generare immagini con Midjourney; la stampa ha fugacemente raccontato l’anno scorso i primi passi di Dall•E (di OpenAI, oggi più nota per ChatGPT; a qualcuno sarà forse capitato di notare l’immagine nata già iconica dell’astronauta a cavallo); ma già nel 2019 Nvidia presentava GauGAN, una tecnologia che produceva immagini realistiche impeccabili a partire da pochi schizzi colorati. E, andando ancora più indietro, nel 2014 Google esplorava questo spazio con Deep Dream. Tutti questi prodotti poggiano a loro volta su tecnologie le cui origini possono essere fatte risalire almeno agli Anni Sessanta.

Da Alexa alla scrittura predittiva dei messaggi, dalla guida assistita alla traduzione online, dalle videocamere di sicurezza agli algoritmi che suggeriscono acquisti o video, le nostre interazioni con le macchine vengono regolate sempre di più da qualche forma di Intelligenza Artificiale (o di Machine Learning, che dell’AI è una specifica applicazione) senza che la riconosciamo necessariamente come tale; questo anche grazie al fatto che la locuzione include uno spettro abbastanza largo di possibilità e gradi di sofisticazione molto diversi fra di loro.

L’esplicitazione della sigla “AI”, poi, non sembra affatto casuale. A volte viene messa in bella evidenza per conferire una allure tecnologica; ciò è particolarmente vero nel fotoritocco (“Luminar AI”, “Topaz DeNoise AI”, la dotazione di “AI features” delle ultime versioni di Photoshop etc.), dove si rincorrono applicazioni capaci di ricostruire dati assenti (con l’aumento di nitidezza o di risoluzione) o di trasformare una scena: cambiando il fuoco, modificando l’illuminazione, correggendo le imperfezioni, scontornando con precisione, rimuovendo oggetti con una pennellata “smart” o sostituendo il cielo con un altro, magari più drammatico, nel tempo di un clic.

Laddove l’elemento tecnologico susciti anche il minimo sospetto invece, magari evocando inconsciamente scenari da Terminator o Matrix, il riferimento a questa presunta “intelligenza non umana” viene più convenientemente omesso.

La verità dell’immagine digitale

Tralasciamo la questione della “verità” dell’immagine fotografica tout-court (terribilmente complessa) limitandoci al tema più circoscritto dell’elaborazione dell’immagine digitale. Il confine tra reale e artificiale è stato ambiguo sin dall’inizio: quando il fotoritocco è passato dalla camera oscura tradizionale al monitor le possibilità di manipolazione sono aumentate vertiginosamente e anche se assistiamo da anni a esilaranti carrellate di “Photoshop fails”, non ci siamo mai veramente abituati a pensare che ciò che vediamo è spesso assai diverso da ciò che si è presentato davanti all’obiettivo.

L’elaborazione facile, veloce, a basso costo e dai risultati di assoluta credibilità ci ha fatto scivolare verso una rappresentazione del mondo astratta, patinata, priva delle banalità degli scenari quotidiani: panorami senza fastidiosi pali della luce, passanti inopportuni che spariscono, dettagli convenientemente raddrizzati; condotte di cui si è macchiato anche qualche celebre fotografo (un peccato veniale che diventa però nel caso del reportage – e qui prendo una posizione netta – un vero e proprio crimine contro la fotografia).

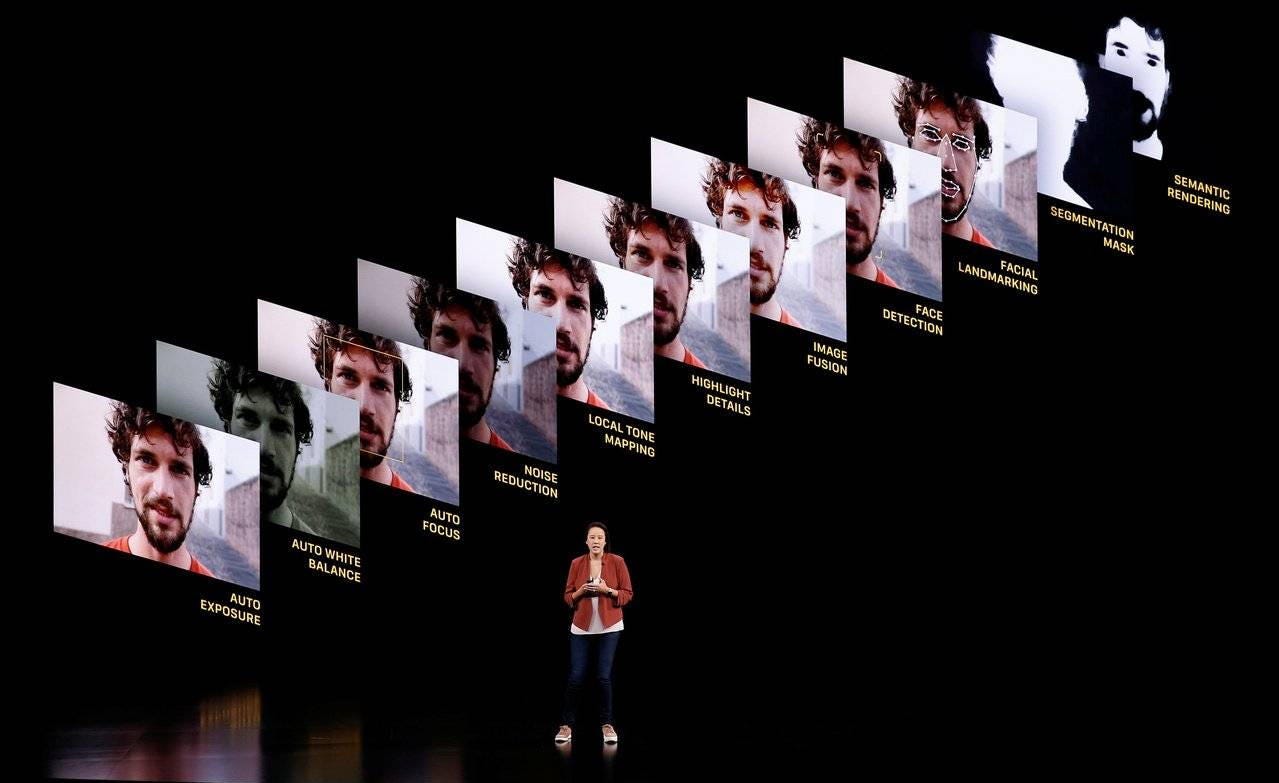

Tecnologie di AI o Machine Learning sono entrate nello stesso processo di ripresa; paradossalmente è ciò che hanno oggi in comune le fotocamere professionali di fascia alta e quelle degli smartphone. Se le prime devono aiutare il fotografo a non perdere dati preziosi per colpa di una impostazione inadeguata, ai secondi è ormai attribuito il compito di scattare foto “belle”. Belle soprattutto per i social: i colori devono essere saturi e vivaci, l’immagine nitida, l’effetto professionale, il tutto con un sensore dalle dimensioni inferiori a quelle di un’unghia. La realtà va quindi decostruita e ricostruita per adattarsi all’aspettativa di chi scatta e soprattutto di chi osserva, in un processo che funziona però solo finché è velato: per quanto detto sopra da un’immagine fotografica ci aspettiamo sempre una sorta di verità e se il trucco viene scoperto non funziona più.

Qualcuno infatti rischia di strafare e qualcun altro questo limite lo oltrepassa in modo piuttosto imbarazzante; ma al di là delle intenzioni è ormai evidente quanta distanza si sia creata tra la luce che attraversa le lenti dell’obiettivo e quella che viene emessa dal nostro display.

L’immagine del corpo

La vera battaglia però si è consumata sul corpo, in particolare il corpo femminile. L’immagine di una donna sempre giovane, sempre magra, sempre più magra, priva di difetto – essendo “difetto” qualunque segno di una corporeità del corpo, di una sua esistenza nello stesso mondo fisico cui apparteniamo noi osservatori – ha costituito da un certo momento in poi un ideale di bellezza obbligatorio e insieme irraggiungibile. Nel 2012 una legge del Parlamento israeliano esprimeva l’esasperazione di fronte all’uso di modelle clinicamente sottopeso e a quello troppo disinvolto del fotoritocco (diventata subito nota come “Photoshop Law”). La bellezza della donna è sempre stata un tema culturale fondamentale, ma si è giunti infine a uno scollamento tra un corpo semplicemente ideale e uno francamente irreale, oserei dire non umano, avvicinabile in concreto solo con dissennate acrobazie di chirurgia plastica.

Mentre moda e comunicazione ripiegavano gradualmente su apparenze più familiari e, cogliendo i nuovi trend, sposavano i principi della body positivity, prendeva inizio però sotto traccia un’altra battaglia, questa volta diretta contro le adolescenti.

Nel 2021, Jonathan Haidt scrive su The Atlantic:

Something terrible has happened to Gen Z, the generation born after 1996. Rates of teen depression and anxiety have gone up and down over time, but it is rare to find an “elbow” in these data sets––a substantial and sustained change occurring within just two or three years. Yet when we look at what happened to American teens in the early 2010s, we see many such turning points, usually sharper for girls.

L’impennata di disturbi mentali nella fascia delle adolescenti – e il suo evidente distacco dalla corrispondente statistica sui coetanei maschi – viene attribuita (con ampia letteratura a supporto) all’ascesa di Instagram:

Social media – particularly Instagram, which displaces other forms of interaction among teens, puts the size of their friend group on public display, and subjects their physical appearance to the hard metrics of likes and comment counts – takes the worst parts of middle school and glossy women’s magazines and intensifies them.

Se per arrivare a queste considerazioni sono stati necessari dieci anni e uno scandalo (grazie al quale è emerso che Facebook era perfettamente al corrente di questi effetti), forse dovremmo iniziare a preoccuparci seriamente di che effetto stia avendo sugli adolescenti (e preadolescenti) di oggi TikTok.

Con Instagram l’utente è artefice intenzionale della propria “falsificazione” (che può spingersi molto in là); con TikTok (che verrà forse ricordato come uno dei più clamorosi esperimenti di ingegneria sociale di massa della storia) questo confine sembra essere saltato: l’app non fornisce un’immagine migliorata solo al pubblico ma anche all’autore – e senza che questi ne sia consapevole: uno specchio bugiardo. “Un bug”, spiegarono quando scoperti; una traiettoria ben studiata (v. MIT Technology Review, The Verge), possiamo legittimamente ritenere.

La corsa all’oro

Torniamo finalmente a Stable Diffusion: cosa è successo? O, meglio, cosa sta per succedere? E perché proprio adesso?

Da un lato OpenAI ha sparato il colpo dello starter nella corsa all’oro dell’AI nel suo complesso. ChatGPT è un Large Language Model, ma questi strumenti sono sviluppati in modo piuttosto integrato e uno fa necessariamente da traino all’altro (OpenAI produce infatti oltre a Dall•E anche un modello speech-to-text molto efficace che si chiama Whisper e molto altro; lo stesso vale per Stability Ai, la società dietro Stable Diffusion). GPT-4, il nuovo modello di OpenAI appena presentato, è già un Large Multimodal Model e può riconoscere, oltre all’input testuale, il contenuto di un’immagine.

Nello spazio di poco più di un mese, tra l’uscita del mio numero precedente sulle AI testuali e oggi, Microsoft ha integrato ChatGPT in Bing molestando Kevin Roose del New York Times, Google ha lanciato in fretta e furia “Bard” lasciando momentaneamente per strada il 9% del proprio valore e Amazon ha aumentato l’investimento in Hugging Face, una società specializzata nell’hosting e nello sviluppo di strumenti AI/ML. Un po’ in ritardo all’appello Apple, che sta prendendo atto di quanto sia imbarazzante Siri, e Tesla che continua a sbattere contro camion fermi.

Insomma, una corsa all’oro scomposta, non senza inciampi, molto concentrata per ora sulle applicazioni di larga scala (e largo ritorno economico) dei modelli linguistici (gravati da alcune intrinseche, gravissime problematicità).

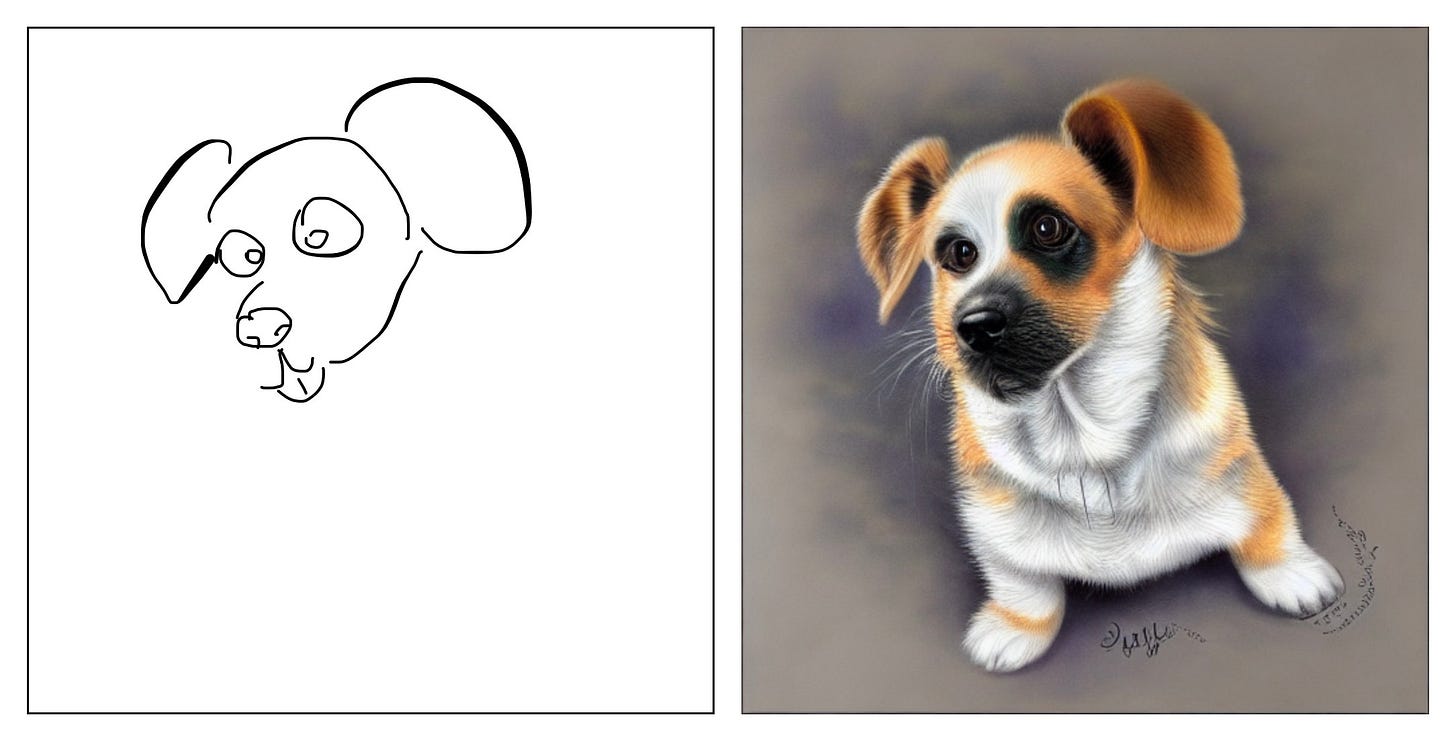

Ma nell’altro campo, quello governato non dalle parole ma dalle immagini, si muove qualcosa di anche più interessante. Stability Ai ha infatti sposato la filosofia Open Source e quando ha rilasciato Stable Diffusion a luglio dello scorso anno si è raccolta intorno ad essa una fibrillante comunità di utenti, creativi e sviluppatori. Avevo provato prima di Natale qualche applicazione molto basilare con risultati divertenti (l’immagine a corredo del primo numero di questa newsletter è stata realizzata in pochi secondi con DiffusionBee), ma nel mese che ho speso a studiare più da vicino il fenomeno ho fatto fatica a seguire il ritmo delle novità che si rincorrevano. Nel giro di una settimana quello che appariva come un problema insormontabile veniva risolto in modo brillante da qualche integrazione – e così via di seguito con il problema successivo. Nel frattempo, queste tecnologie open si trasferivano su una miriade di applicazioni a volte rudimentali ma anche per lo più gratuite e distribuite su ogni tipo di dispositivo (sono già disponibili plug-in per inserire Stable Diffusion nel flusso di lavoro di Photoshop e Blender senza nemmeno uscire dall’applicazione).

I baffi di Superman

Non si faccia ingannare, l’eroico lettore che è giunto fin qui, dalla qualità del mio cagnolino: con competenze minime e ottenibili rapidamente è possibile ottenere risultati decisamente superiori: ne è testimonianza nientepopodimeno che Superman.

Mentre stava girando “Mission: Impossible - Fallout”, Henry Cavill fu richiamato per rifare alcune scene di “Justice League”. Per esigenze di copione aveva però i baffi: si decise di girarle ugualmente per poi rimuoverli digitalmente in post-produzione. Il risultato non è stato particolarmente apprezzato dai fan, soprattutto considerando i 300 milioni di dollari di budget del film. La scena è stata ripassata in Stable Diffusion (con ControlNet e EbSynth, per la precisione) da un utente di Reddit e vi lascio decidere quale sia riuscita meglio.

Già oggi, con un computer di modeste capacità è possibile realizzare scene fotorealistiche completamente sintetiche così verosimili da richiedere molta attenzione (e una certa competenza) per dimostrarne l’origine artificiale. In breve, sta avvenendo per l’immagine sintetica quello che è già avvenuto anni fa per il ritocco digitale. Le tecnologie coinvolte stanno diventando:

disponibili gratuitamente o a basso prezzo

disponibili su hardware accessibile, inclusi dispositivi d’uso quotidiano come gli smartphone

capaci di ottenere prodotti di totale verosimiglianza

che richiedono una curva di apprendimento minima o nulla

che amplificano le capacità creative dell’utente, incentivandone l’assunzione

In poche parole: ubiquitarie e a bassa frizione. Le profezie in campo tecnologico sono sempre imprudenti, ma credo che il 2023 sarà un anno di grandi trasformazioni, nel bene e nel male. Ho scritto nel numero scorso:

Esisterebbe, sì, un lungo discorso da fare sulla “verità” delle immagini… Per adesso limitiamoci a sottolineare che, nonostante simili pericoli, immagine e testo hanno due “nature” sostanzialmente diverse ed è più corretto trattarle diversamente.

Crediamo al testo in un atto di fiducia nei confronti dell’autore; crediamo alle immagini perché crediamo ai nostri sensi. Le due modalità, per quanto possano portare agli stessi effetti (e per quanto spesso coesistano), sono radicalmente distinte.

Se tutto è falso, non c’è più inganno

Sono sempre convinto che le AI basate sui LLM, usate impropriamente, rappresentino un rischio proprio per come sono progettate; peggio ancora se dovessero essere inserite in qualunque forma di processo decisionale.

Al contrario, potrebbe non esserci miglior notizia della diffusione e popolarizzazione delle immagini sintetiche. A oggi, per fare un esempio, il potenziale disinformativo di un deep fake ben fatto può essere devastante. Ma che impatto avrebbe se ciascuno di noi potesse creare quello stesso deep fake sul telefonino mentre aspetta l’autobus? Che effetto ha sulla salute mentale di un’adolescente l’immagine apparentemente perfetta di una coetanea se è interiorizzato il fatto che ogni immagine è, in qualche modo, artificiale?

La maschera più pericolosa è quella che non vediamo: forse, per farla cadere, dobbiamo indossarne tutti una ben visibile.

Grazie per l’attenzione,

Cristiano M. Gaston

Post Scriptum

Questo articolo è stato completamente riscritto: nella sua versione originale prendevo le mosse da questioni molto più tecniche sì da giustificare le mie conclusioni; mentre andavo avanti mi rendevo conto però che il contenuto si stava dilatando enormemente e che le novità si inseguivano così rapidamente da rendere il pezzo vecchio ancor prima di essere finito. Ho deciso quindi di rinunciare completamente a questo approccio e costringere chi mi legge a un atto di fiducia: i prodotti già usciti e quelli di imminente rilascio sono però piuttosto straordinari e i prossimi mesi saranno decisamente interessanti. Solo nell’ultima settimana, giusto per fare alcuni esempi, sono arrivati la versione 5 di Midjourney, GPT-4 (che si scopre essere stato discretamente integrato in Bing già da un po’ e che come scritto sopra riconosce anche le immagini), Copilot è in corso di integrazione in Microsoft Office e siamo allo scadere del conto alla rovescia per Gen-2, il modello text-to-video di RunwayML (un altro degli sviluppatori di Stable Diffusion).

C’è anche un altro risvolto che avevo iniziato ad affrontare e cui ho dovuto rinunciare per questioni di spazio e di tema: il ruolo della creatività, sia quella di chi usi questi strumenti che quella di chi ha prodotto le opere su cui questi strumenti sono addestrati, spesso senza un esplicito consenso.

Non è escluso che da tutti questi “scampoli”, senza pretesa di fare un discorso organizzato, esca fuori un altro numero. Insomma, c’è ancora molto da dire.

Suggestioni

La persona da tenere d’occhio – non l’unica, ma quella con la prospettiva più inconsueta e, al netto di un certo utopismo caratteristico dei founders, anche culturalmente più ricca – è Emad Mostaque di Stability Ai; consiglio vivamente di ascoltare tre sue interviste:

a Nina Schick, 15 dicembre 2022

per Moonshots and Mindsets, 22 dicembre 2022

per The Logan Bartlett Show, 6 gennaio 2023

Verità e fotografia

Della “verità della fotografia” ho parlato in un video qualche tempo fa: